1990年代後半から2000年代初頭のインターネット黎明期において、その後のネット社会の定着を決定づけたのが「検索エンジン」の登場でした。気になることや知らないことは、ネット検索で解決できる時代が到来。後に検索エンジンで圧倒的なシェアを誇ることになるGoogleで調べることを「ググる」という言葉が代表されるように、「ネット検索が当たり前の時代」が長らく続いています。そして、近年では検索に加えて、AIとの壁打ちが疑問や問題の解消のための1つの方法論として確立されつつあります。

NLG(自然言語生成/Natural Language Generation)の領域に限定したとしても、OpenAIの「ChatGPT」を筆頭に、Googleの「Gemini」、Anthropicの「Claude」、Microsoftの「Copilot」、xAIの「Grok」など人々の暮らしにおいて、AI活用はもはや当たり前となりました。そんな検索エンジンをググるから、AIでジピる(ChatGPTで調べる)文化に移り変わりつつあるAI全盛時代において、1つ気をつけるべきことがあります。それが、生成AIが嘘をつく(誤情報を展開する)「ハルシネーション(Hallucination)」という現象です。ハルシネーションによってどんな問題が生じるのか、そして、その対処法についても紹介します。

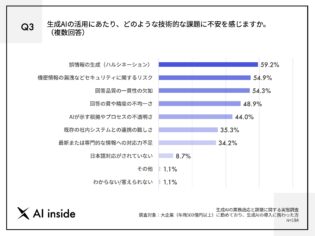

約6割が生成AIの活用への不安として「ハルシネーション」と回答

AI inside「生成AIの業務適応と課題に関する実態調査(https://inside.ai/news/2024/1017_gen-ai-hallucination-issue)」より引用

すでにインターネット内にあるコンテンツを見つけ出す検索と比較して、AIによって導き出される回答は即興性と独自性があると考えられています。お題として展開されたプロンプト(AIに対する指示・命令)に対して、ネットワーク上にある情報を探し、自主学習し、精査したうえで返答するのがAIとの壁打ちの特徴です。そのため、現在ではWeb施策においても検索エンジン対策だったSEO(Search Engine Optimization/検索エンジン最適化)からAI対策としてのLLMO(Large Language Model Optimization/大規模言語モデル最適化)へと移行しつつあります。

AIがより一般的に活用されることは時代の流れからすると至極当然のことですが、ここで問題になるのが生成AIによって導き出される回答が嘘(誤情報)である恐れがある点です。それは「ハルシネーション(幻覚)」と呼ばれていて、AI全盛時代ならではの新たなリスクとして注意喚起がなされています。AIは言語を生成する際に、膨大なインターネット上の情報にアクセスしてリサーチしたうえで回答を導き出します。その際にソースが正しくなかったり、ディープラーニングにおける理論構築において綻びがあったりすると事実に基づかない回答が生成されてしまう事象が発生します。まるでAIが幻覚に惑わされるように誤情報を導き出すことからハルシネーションと呼ばれるようになりました。

AIプラットフォームを提供するAI inside 株式会社が年商500億円以上の大企業に勤務し、なおかつ生成AIの導入に関わった方を対象にして行った「生成AIの業務適応と課題に関する実態調査」では、生成AIの活用への不安として59.2%が誤情報の生成(ハルシネーション)を挙げたという統計結果を公開しています。AIもまだまだ発展途上な面もあり、導き出される回答が必ずしもベストであるとは限らない点は、活用するうえで肝に銘じるべきでしょう。

かつて検索においても過度なSEO対策によって誤情報や無関係な情報が上位表示を独占してしまう過去があり、Googleが検索品質評価として、「Experience(経験)」「Expertise(専門性)」「Authoritativeness(権威性)」「Trustworthiness(信頼性)」のE-E-A-Tを重視するようになった経緯を踏まえ、AI活用においても情報の整合性を確かめる対策が不可欠だと言えます。

情報の種類を正しく分類したうえでのファクトチェックが不可欠

AIと壁打ちをしたことがある方でしたら、その返答の早さについてはもはや言わずもがなでしょう。しかし、その回答を鵜呑みにしてしまうとハルシネーションの罠に陥る危険性がある点は、前述した通りです。では、AI活用において情報の整合性を確かめるうえでは、日頃からどのようなことに気をつけるべきでしょうか。対策として挙げられるのは、「情報の種類を正しく分類すること」「種類を把握したうえで情報のファクトチェックをすること」の2点です。

まず、なぜ情報の種類を正しく分類する必要があるかというと、世の中に出回っている情報が必ずしも正しい情報とは限らない点が挙げられます。しかも、それが生成AIによって意図せずに違った解釈になってしまった情報ならまだしも、フェイクニュースなど意図的に噓情報を作り出すことである対象を傷つけたり、利益を得たりしている悪意を持った団体や個人もいることに注意を払わなければなりません。普段から身の回りにある情報をきちんと精査して、その整合性を問うことを習慣化しましょう。情報の分類としては下記の表の通りです。

【情報の定義】

| 正規の情報 True Information |

公的機関や研究機関がリリースしている客観的な証拠やデータによって裏付けられる情報。科学的な研究結果や統計データ、公式文書、事実に基づいた報道などが該当する。 |

| 誤報 Misinformation |

間違いがあるにもかかわらず、正しいと信じられて広まった情報。意図的な悪意がなく流布してしまう点が特徴。情報の不足、誤解、不注意などヒューマンエラーによって間違いが発生する。思い込みや臆測、情報の鮮度の低さによって整合性が取れなくなる恐れがある情報。 |

| 偽情報 Disinformation |

意図的に騙したり、特定の目的のために大衆の印象操作をしたりする目的で作成・拡散される間違った情報。誤報とは異なり、情報を広める側に明確な悪意や目的がある点が特徴となる。フェイクニュースは偽情報の最たる例。 |

| 悪意の情報 Malinformation |

仮に事実に基づいていたとしても、悪意を持って活用したり、文脈から切り離して特定の個人や団体を傷つけたり、操作したりするために利用される情報。ハッキングで得られた個人情報や機密情報の意図せぬ公開やプライベートな内容を暴露についても該当する。 |

上記のように情報と一口に言っても大まかに4種類に分類され、正しくない情報に関しても3つ(誤報、嘘情報、悪意の情報)に分類されることを意識しましょう。そして、3つの正しくない情報については、日頃からのファクトチェックを意識することで、情報の真贋を見抜くトレーニングをしましょう。生成AIの活用は非常に便利であり、特に業務面においては作業の効率化や時間短縮に大きく寄与してくれる可能性があります。ただ、それはまとめられた内容が正規の情報であることが前提になるので、AIがハルシネーションを起こしている(嘘をついている)リスクはないかというアンテナを常に張って情報と向き合うことが求められるでしょう。

生成AIと向き合って調整する「ファインチューニング」を意識

生成AIが言語を作成するうえで、ソースにする情報には前述の通り正しくない情報も含まれることもあります。そのため、内容に関して適宜ファクトチェックをすることはもちろんですが、AIが生成する内容の精度を高めるためにも、「ファインチューニング(Fine-tuning/微調整)」が欠かせません。ファインチューニングとは、生成AIがすでに学習済の内容に加え、独自のデータなどを追加で学習させることでAIの回答をチューニングする技術です。

生成AIに関しては、プロンプトやディープラーニングの精度が低いと望むような回答が得られにくいことは、すでに多くの方が実感していることでしょう。そこで「精度が低い」「人間と比べて分からない領域がある」と突き放してしまうのではなく、地道にチューニング作業をすることが活用においての質を高めることにつながります。特に仕事での業務への活用を念頭に置くのであれば、ファインチューニングの手間を惜しまないことが推奨されるでしょう。

日進月歩で進化を遂げているAIは非常にハイスペックであり、人間の想像を遥かに超えるポテンシャルを秘めています。しかし、一方でそんなAIもハルシネーションを起こしてしまう、完全無欠なツールではないことも確かです。前述したように情報を間違えて解釈することもあれば、意図をせず嘘をつくこと、悪意ある情報に騙されてしまうこともあるでしょう。だからこそ、AIに指示をする人間がしっかりと向き合ってプロンプトの精度を高めるなどファインチューニングを意識することが大前提となります。

今後はAI技術がシンギュラリティ(Singularity/ AIが人間の知能を超える時点)を迎え、ASI(Artificial Superintelligence/人工超知能)にまで発展する時代の到来が予見されています。超知性に対してファインチューニングなどは必要なくなるかもしれませんが、現状におけるAIと正しく向き合うためには、人と接するのと同様に根気強く課題解決のための策を講じるしかないでしょう。AI全盛時代に生成AIを使いこなすビジネスパーソンになるためには、ハルシネーションに対して一喜一憂するのではなく、AIの特性を把握して温かくカバーできる懐の深さを見せることも大切なのかもしれません。

【関連記事】

テクノロジーによる人間拡張の可能性 人類が手にするIoAを活用した超知性

AIの次はOIがバイオコンピューターを実現? オルガノイドインテリジェンスとは